Google cerca di salvare i propri creatori Sergey Brin e Larry Page dagli implacabili robots Terminator. L'umorismo è di casa a Mountain View, quelli di Big G non sono certo dei musoni, e se ne inventano sempre una nuova per strapparci un sorriso.

Google cerca di salvare i propri creatori Sergey Brin e Larry Page dagli implacabili robots Terminator. L'umorismo è di casa a Mountain View, quelli di Big G non sono certo dei musoni, e se ne inventano sempre una nuova per strapparci un sorriso.

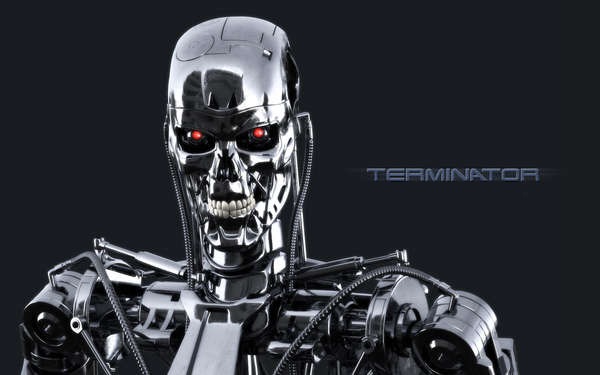

Il 30 giugno 2014, per il ventesimo anniversario della nascita del file robots.txt, Google si diverte e ci fa divertire con uno speciale file robot.txt, nel quale ordina ai due robots T-800 e T-1000 (della serie cinematografica Terminator) di non uccidere i suoi fondatori. Non ci credete? Continuate a leggere e vedrete.

Provate ad andare al seguente indirizzo:

http://www.google.com/killer-robots.txt

Troviamo un file robot caricato da Google con le seguenti istruzioni

User-Agent: T-1000

User-Agent: T-800

Disallow: /+LarryPage

Disallow: /+SergeyBrin

Con queste righe Google intima ai due User-Agent (noti anche come crawler o robots) di escludere dalle loro ricerche Sergey Brin e Larry Page, ovvero i due fondatori del famoso motore di ricerca. Ah Ah Ah davvero spassosissimo.

Per chi non l'avesse capita, la spiego brevemente.

I T-800 e T-1000 sono le sigle con le quali nella serie dei film Terminator, s'indicano due differenti versioni dei terribili terminator, robot umanoidi con il solo scopo di uccidere il genere umano. Quando ad un terminator viene impartito l'ordine di uccidere un soggetto, il robot comincia a cercarlo e non si arresta fino a quando non compie la sua missione, ossia terminare il soggetto. Solo Sarah Connor e suo figlio John nel primo e secondo capitolo della serie riusciranno a sfuggirgli.

Gli User Agent, anche chiamati crawler o robots (ecco l'analogia) sono invece dei software automatizzati che scansionano il web indicizzando i contenuti delle pagine, ve ne sono diversi, alcuni con compiti specifici e nomi differenti. I motori di ricerca tramite i contenuti forniti dagli user-agent sono in grado poi di fornire i risultati quando effettuiamo una ricerca. Il file robots invece è un semplice file di testo che ogni webmaster può caricare sul proprio server, nel quale fornisce direttive sul comportamento da tenere da parte dei robots che arrivano sul sito, ad es. può dire di non leggere il contenuto di una cartella oppure impedire l'indicizzazione dell'intero sito ad un particolare user-agent e così via.

Ecco così che Google per impedire l'implacabile ricerca dei robot "terminator", carica sul proprio server un file killer-robots.txt che ordina ai due robot (user agent) T-800 e T-1000 di non cercare Brin e Page (istruzione Disallow: /+), riuscendo così a salvare i suoi fondatori dalle terribili macchine assassine... Ah ah ah, non lo trovate geniale e divertente allo stesso tempo?